TII lance Falcon Reasoning : le meilleur modèle d’IA 7B au monde, surpasse et rivalise avec des modèles d’IA plus volumineux

- Falcon H1R 7B : un modèle compact de 7 milliards de paramètres intégrant un raisonnement avancé, optimisé pour la rapidité et l’efficacité

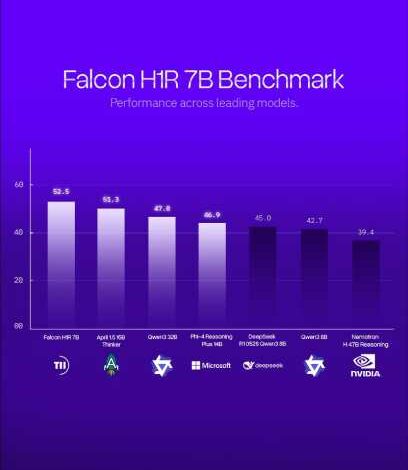

- Le dernier modèle d’IA de TII surpasse des concurrents plus volumineux de Microsoft, Alibaba et NVIDIA sur les principaux benchmarks

Le Technology Innovation Institute (TII), pilier de recherche appliquée de l’Advanced Technology Research Council (Conseil de recherche en technologies avancées – ATRC) d’Abou Dhabi, a annoncé le lancement de Falcon H1R 7B, un modèle d’IA de nouvelle génération qui marque une avancée majeure vers une accessibilité universelle et accrue de l’intelligence artificielle avancée, en offrant des capacités de raisonnement de niveau mondial dans un format compact, efficace et librement accessible.

Avec seulement 7 milliards de paramètres, Falcon H1R 7B rivalise avec, et dans de nombreux cas surpasse, des modèles d’IA open source de plus grande envergure développés à l’échelle mondiale, notamment ceux de Microsoft (Phi 4 Reasoning Plus 14B), d’Alibaba (Qwen3 32B) et de NVIDIA (Nemotron H 47B). Le lancement de ce modèle réaffirme la position de TII à l’avant-garde de l’innovation en matière d’IA efficiente et renforce l’influence croissante des Émirats Arabes Unis et son leadership technologique mondial.

Son Excellence Faisal Al Bannai, conseiller du Président des Émirats Arabes Unis et secrétaire général de l’Advanced Technology Research Council, a déclaré : « Falcon H1R incarne pleinement l’engagement des Émirats Arabes Unis à développer une intelligence artificielle ouverte, responsable et à fort impact, capable de générer une valeur tangible aux niveaux national et mondial. En intégrant des capacités de raisonnement de tout premier plan au sein d’un modèle à la fois compact et hautement efficient, nous démocratisons l’accès à l’IA avancée d’une manière qui stimule la croissance économique, renforce le leadership en matière de recherche et consolide la résilience technologique à long terme ».

Une avancée majeure dans le raisonnement au moment de l’inférence

Falcon H1R 7B s’appuie sur la base Falcon H1-7B, grâce à une approche d’entraînement spécialisée et une architecture hybride Transformer–Mamba, permettant d’améliorer à la fois la précision et la rapidité.

« Falcon H1R 7B représente une avancée décisive dans les capacités de raisonnement des systèmes d’intelligence artificielle compacts », a déclaré la Dre Najwa Aaraj, PDG de TII. « Le modèle atteint des performances proches de la perfection sur des benchmarks de tout premier plan, tout en conservant une empreinte mémoire et énergétique remarquablement faible — des critères déterminants pour un déploiement réel à grande échelle, ainsi que pour des usages durables et responsables ».

Cette approche permet de libérer ce que les chercheurs qualifient d’« intelligence latente », offrant à Falcon H1R 7B une capacité de raisonnement plus efficace et plus performante. Le modèle établit ainsi une nouvelle frontière de Pareto, un point d’équilibre optimal où l’augmentation de la vitesse ne se fait pas au détriment de la qualité.

Des performances de référence parmi les meilleures

Lors de benchmarks compétitifs, Falcon H1R 7B a enregistré des résultats remarquables :

- En Mathématiques : Falcon H1R 7B a atteint un score de 88,1 % sur AIME-24, surpassant Apriel 1.5 (15B) de ServiceNow AI (86,2 %), démontrant qu’un modèle compact de 7B paramètres peut rivaliser, voire dépasser, des systèmes de bien plus grande taille.

- Dans la Programmation et les tâches agentiques : le modèle a affiché un taux de précision de 68,6 %, une performance de premier plan parmi les modèles de moins de 8B paramètres, et a obtenu des scores supérieurs sur les benchmarks LCB v6, SciCode Sub et TB Hard, avec un score de 34 % pour Falcon H1R, contre 26,9 % pour le modèle chinois DeepSeek R1-0528 Qwen 3 8B, dépassant même des concurrents plus volumineux tels que Qwen3-32B (33,4 %).

- Dans le raisonnement général : Falcon H1R a démontré de solides capacités logiques et de suivi des instructions, égalant ou approchant les performances de modèles plus importants comme Phi 4 Reasoning Plus (14B) de Microsoft, tout en n’utilisant que la moitié des paramètres.

- Efficience : a atteint jusqu’à 1 500 tokens/seconde/GPU avec un batch de 64, soit près du double de la vitesse du Qwen3-8B chinois, grâce à son architecture hybride Transformer–Mamba, offrant des performances plus rapides et hautement évolutives sans compromis sur la précision.

« Ce modèle est l’aboutissement de travaux de recherche et d’ingénierie de classe mondiale. Il démontre avec force que la précision scientifique et une conception pensée pour l’évolutivité peuvent avancer de concert », a déclaré le Dr Hakim Hacid, chercheur en chef au Centre de recherche en intelligence artificielle et numérique de TII. « Nous sommes fiers de mettre à disposition de la communauté un modèle qui lui permet de développer des systèmes d’IA toujours plus intelligents, plus rapides et plus accessibles ».